Chatbot ist nicht gleich Chatbot – Warum Unternehmenswissen den Unterschied macht

Warum moderne Chatbots nur dann echten Mehrwert schaffen, wenn sie auf Unternehmenswissen basieren – und wie Datenqualität, RAG und Grounding dabei eine zentrale Rolle spielen.

Chatbot ist nicht gleich Chatbot

Chatbots sind in den letzten Jahren deutlich intelligenter geworden. Was früher einfache Antwortmaschinen waren, die feste Regeln oder FAQ-Listen abgearbeitet haben, kann heute komplexe Zusammenhänge verstehen, Texte zusammenfassen, Empfehlungen geben oder ganze Arbeitsabläufe begleiten.

Dahinter steckt ein Prinzip, das man als Grounding mit eigenem Unternehmenswissen bezeichnet. Das bedeutet: Der Chatbot greift nicht nur auf sein allgemeines Sprachwissen zurück, sondern wird mit dem individuellen Wissen eines Unternehmens verbunden – mit Richtlinien, Handbüchern, Verträgen, Projektdaten oder Prozessen. Er weiß also, wie das Unternehmen wirklich funktioniert. Und genau das eröffnet völlig neue Einsatzmöglichkeiten.

Chatbots als digitale Assistenten im Unternehmen

Chatbots sind heute weit mehr als ein Support-Tool auf der Website. Richtig umgesetzt, können sie in vielen Unternehmensbereichen echten Mehrwert schaffen – im Support, im Onboarding, bei der Fehleranalyse, in HR-Prozessen oder im Wissensmanagement. Solche Systeme sind ein Schritt in Richtung digitale Organisation: nicht mehr nur digitalisiert, sondern wirklich wissensfähig.

Warum Wissen nicht gleich Wissen ist

Sobald man einen Chatbot mit Unternehmenswissen verbinden will, stellt sich die Frage, welche Art von Wissen überhaupt vorliegt.

| Datentyp | Beispiele | Charakter |

|---|---|---|

| Strukturierte Daten | JSON, Datenbanken (SQL/NoSQL), CRM-Einträge, Tabellen, Kennzahlen, Logfiles | Sauber organisiert, klar typisiert, leicht abzufragen |

| Unstrukturierte Daten | PDFs, E-Mails, Präsentationen, Texte, Handbücher, Bilder | Enthalten wertvolles Wissen – aber in freier, nicht maschinenlesbarer Form |

Gerade unstrukturierte Daten sind die eigentliche Wissensquelle eines Unternehmens: Dokumentationen, Mails, Verträge oder Schulungsunterlagen. Sie enthalten nicht nur Fakten, sondern auch Kontext und Erfahrung. Leider sind sie oft schwer zugänglich, weil sie in verschiedenen Formaten oder Systemen abgelegt sind.

Wie Chatbots wirklich verstehen lernten

Ich erinnere mich gut an die ersten Chatbots – sie waren ehrlich gesagt ziemlich nervig. Vordefinierte Antworten, starre Abläufe, kaum Verständnis für das, was man wirklich meinte. Viele solcher Systeme sind leider bis heute im Einsatz und erzeugen wenig bis gar keinen Mehrwert.

Mit den neuen Sprachmodellen hat sich das stark verändert. Chatbots können heute Sprache verstehen, den Kontext erkennen und ganze Gespräche führen. Aber erst wenn sie mit echtem Unternehmenswissen verbunden sind, entsteht wirklicher Nutzen – Antworten, die relevant, aktuell und verlässlich sind.

Dieser Ansatz wird als Grounding bezeichnet. Das Sprachmodell arbeitet dabei nicht mehr nur mit allgemeinem Weltwissen, sondern mit den Informationen, die im Unternehmen tatsächlich gelten. Das Konzept, das sich dabei etabliert hat, nennt sich RAG – Retrieval-Augmented Generation.

Von der Idee zum System: Was hinter RAG steckt

RAG kombiniert zwei Fähigkeiten: das gezielte Finden relevanter Informationen im Unternehmenswissen (Retrieval) und das anschließende Formulieren einer passenden Antwort durch ein Sprachmodell (Generation).

Das Besondere: Das Modell selbst wird nicht verändert oder neu trainiert, sondern erhält bei jeder Anfrage nur die relevanten Ausschnitte aus den eigenen Daten. Dadurch bleiben Systeme aktuell, nachvollziehbar und skalierbar. Neue Informationen können jederzeit hinzugefügt werden, ohne das Modell erneut trainieren zu müssen.

RAG im Vergleich zu anderen Ansätzen

Wenn man Chatbots auf Unternehmenswissen aufbauen möchte, gibt es drei Wege, die sich in Aufwand und Nutzen deutlich unterscheiden.

| Ansatz | Beschreibung | Vorteile | Nachteile |

|---|---|---|---|

| Fine-Tuning | Das Sprachmodell wird mit eigenen Unternehmensdaten nachtrainiert. | Dauerhafte Integration des Wissens, keine externe Datenbank nötig | Aufwendig, teuer, schwer zu aktualisieren, problematisch bei sensiblen Daten |

| CAG (Context-Augmented Generation) | Das LLM bekommt bei jeder Anfrage den passenden Kontext – etwa Dokumentauszüge – direkt in den Prompt. | Schnell umsetzbar, kein Training nötig, ideal für kleine Datensätze | Trotz großer Kontextfenster vieler moderner Modelle (100k Tokens) bleiben Ergebnisse oft ungenau, wenn zu viel Inhalt gleichzeitig übergeben wird. Hohe Kosten pro Anfrage durch lange Prompts |

| RAG (Retrieval-Augmented Generation) | Wissen wird vektorisiert, gespeichert und bei jeder Anfrage gezielt abgerufen. | Skalierbar, präzise, nachvollziehbar, aktuell | Höherer technischer Aufwand, abhängig von guter Datenaufbereitung |

CAG ist oft ein schneller Einstieg, Fine-Tuning eignet sich für geschlossene Domänen. RAG-Systeme sind jedoch heute der Standard, wenn es darum geht, Unternehmenswissen sicher und aktuell nutzbar zu machen.

Was macht einen guten Chatbot aus

Unabhängig von der Technologie zählt am Ende das Nutzungserlebnis. Ein Chatbot ist nur dann wirklich gut, wenn er drei Dinge in Balance bringt.

| Faktor | Bedeutung | Herausforderung |

|---|---|---|

| Performance (Schnelligkeit) | Antworten müssen zügig kommen. | Zu starke Optimierung auf Geschwindigkeit kann die Genauigkeit verringern. |

| Genauigkeit (Inhaltliche Präzision) | Der Chatbot muss relevante, nicht oberflächliche Antworten liefern. | Zu viele Daten verlangsamen, zu wenige verfälschen das Ergebnis. |

| Halluzinationsarmut (Verlässlichkeit) | Er soll keine erfundenen oder falschen Aussagen treffen. | Vollständige Halluzinationsfreiheit ist kaum erreichbar, aber sie kann deutlich reduziert werden. |

Die Kunst besteht darin, diese drei Dimensionen auszubalancieren. Zu viel Geschwindigkeit macht den Bot oberflächlich, zu viel Komplexität macht ihn langsam, und ein unkontrolliertes Sprachmodell kann trotz guter Daten falsche Antworten erzeugen.

Im Unternehmenskontext gilt: Geschwindigkeit schafft Akzeptanz, Genauigkeit schafft Nutzen und Verlässlichkeit schafft Vertrauen.

Wenn die Daten widersprüchlich sind

Hier liegt eine der größten Herausforderungen: die Datenqualität. Viele Unternehmen erwarten, dass ein Chatbot automatisch die Wahrheit findet, selbst wenn sich Informationen widersprechen. Das funktioniert so nicht.

Ein Beispiel: In einem Dokument steht, dass Vollzeitbeschäftigte 30 Urlaubstage haben. In einem anderen Dokument steht etwas anderes, bezogen auf Teilzeit. Beide Aussagen sind richtig, aber der Chatbot weiß nicht, welche Regel wann gilt. Das Ergebnis sind unklare oder widersprüchliche Antworten.

Viele Unternehmen ziehen daraus leider den falschen Schluss: Unsere Daten sind schlecht, also brauchen wir mit KI gar nicht erst anfangen. Das ist ein gefährlicher Denkfehler. Denn wer so denkt, wird seine Datenqualität nie verbessern und bleibt stehen, während andere lernen, mit Unsicherheiten umzugehen.

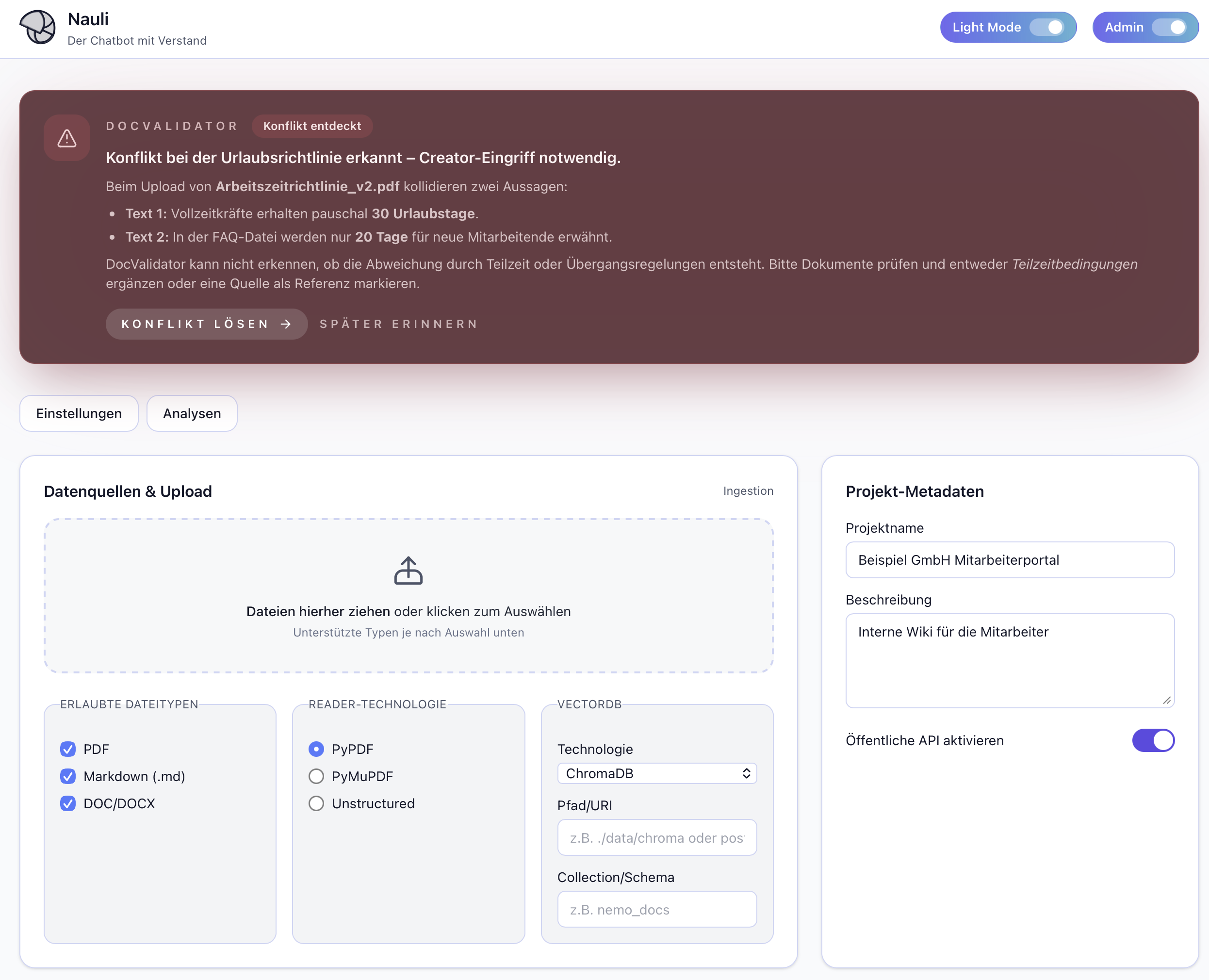

Bei Kunftia sehen wir das anders. Daten müssen nicht perfekt sein, aber Systeme sollten mit Unschärfen umgehen können. In unserem Chatbot Nauli haben wir zwei Mechanismen entwickelt, die genau dabei helfen.

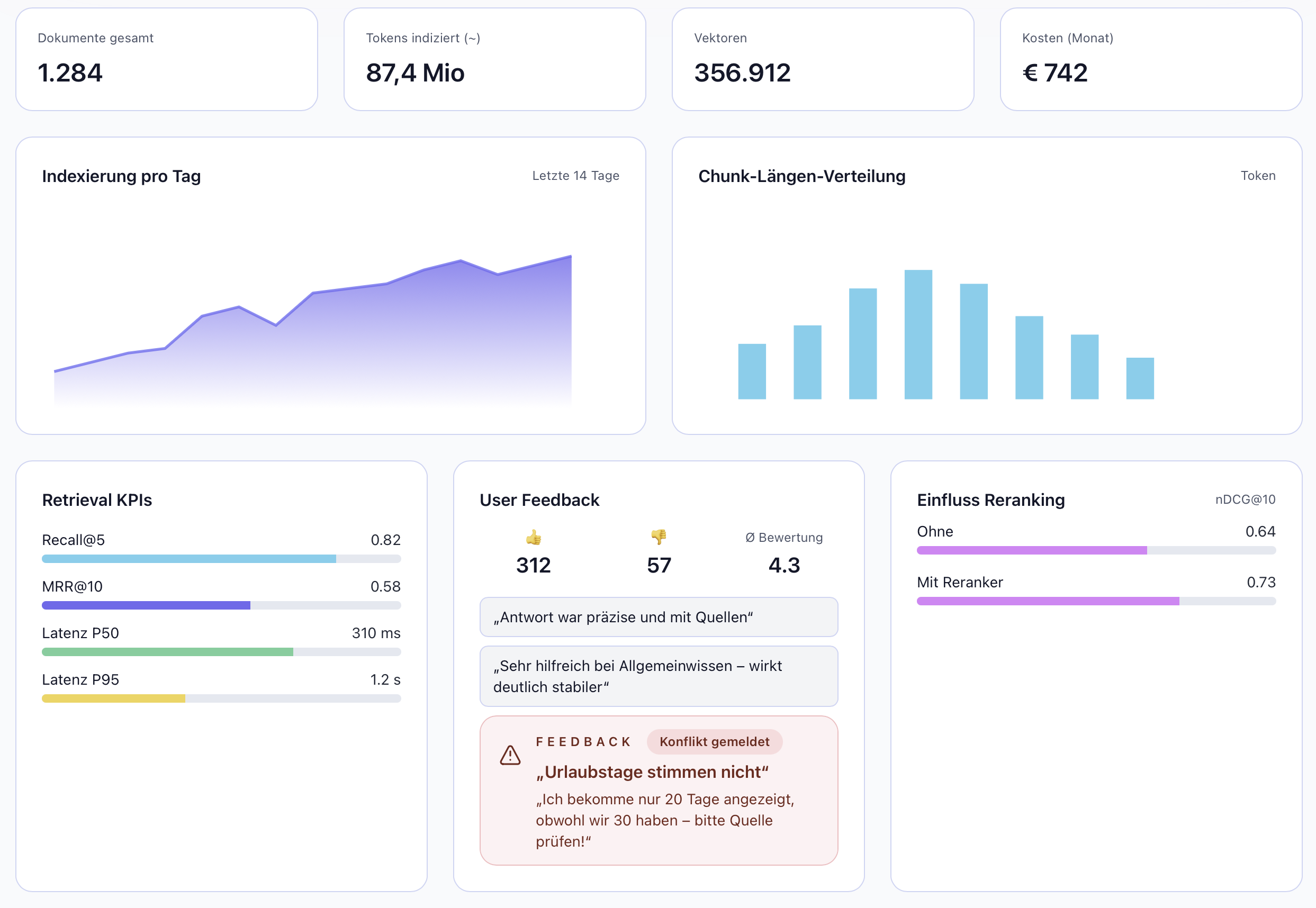

- 1. DocValidator: prüft neue Dokumente beim Hochladen automatisch auf potenzielle Widersprüche, doppelte Inhalte oder unklare Formulierungen und gibt konkrete Hinweise an den Creator (Chatbot-Administrator).

- 2. Feedback-Funktion: ermöglicht es Nutzern, direkt im Chat unklare oder widersprüchliche Antworten zu melden. Das Feedback landet beim Creator und kann gezielt zur Verbesserung der Wissensbasis genutzt werden.

So entsteht ein System, das nicht Perfektion voraussetzt, sondern Schritt für Schritt besser wird – mit jeder Interaktion. Echte Qualität entsteht nicht durch perfekte Daten, sondern durch einen Prozess, der Fehler sichtbar und korrigierbar macht.

Blog 2: Wie Chatbot auf RAG-Basis arbeiten.